Искусственный интеллект стал обучаться в 10 раз быстрее и эффективнее

Подразделение компании Google, занимающееся разработками искусственного интеллекта, сообщило о создании нового метода обучения нейронных сетей, сочетающего использование передовых алгоритмов и старых видеоигр. В качестве среды обучения используются старые видеоигры Atari.

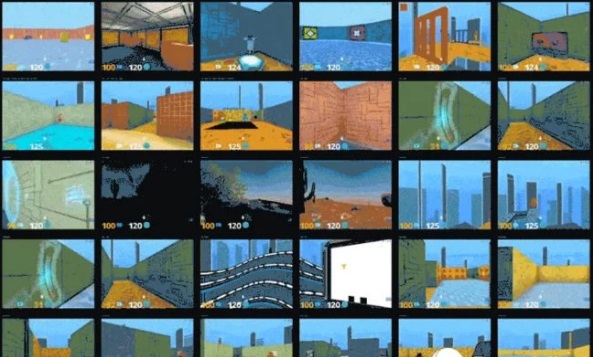

Разработчики DeepMind (напомним, что эти люди создали нейросеть AlphaGo, неоднократно победившую лучших игроков в логическую игру го) считают, что машины способны обучаться так же, как люди. С помощью тренировочной системы DMLab-30, созданной на базе шутера Quake III и аркадных игр Atari (используются 57 различных игр), инженеры разработали новый алгоритм машинного обучения IMPALA (Importance Weighted Actor-Learner Architectures). Он позволяет отдельным частям обучаться выполнению сразу нескольких задач, а потом обмениваться знаниями между собой.

Во многом новая система была основана на более ранней архитектурной системе A3C (Asynchronous Actor-Critic Agents), в которой отдельные агенты исследуют среду, затем процесс приостанавливается, и они обмениваются знаниями с центральным компонентом, «учеником». Что касается IMPALA, то у нее агентов может быть больше, а сам процесс обучения происходит несколько по-другому. В ней агенты посылают информацию сразу двум «ученикам», которые после этого еще и обмениваются данными между собой. Кроме того, если в A3C вычислением градиента функции потерь (другими словами, несоответствия предсказанных и полученных значений параметров) занимаются сами агенты, которые отправляют информацию к центральному ядру, то в системе IMPALA этой задачей занимаются «ученики».

Пример прохождения игры человеком:

Здесь показано, как с такой же задачей справляется система IMPALA:

Одной из основных проблем при разработке ИИ является время и необходимость в высокой вычислительной мощности. Даже в условиях автономности машинам нужны правила, которым они могли бы следовать в ходе собственных экспериментов и поиска путей решения задач. Так как мы не можем просто построить роботов и выпустить их на волю учиться, разработчики используют симуляции и методы глубокого обучения.

Для того чтобы современные нейронные сети могли чему-то научиться, им приходится обрабатывать огромный объем информации, в данном случае — миллиарды кадров. И чем быстрее они это делают, тем меньше времени уходит на обучение.

По словам представителей DeepMind, при наличии достаточного числа процессоров IMPALA достигает производительности в 250 000 кадров/с, или 21 миллиард кадров в день. Это абсолютный рекорд для задач такого рода, сообщает портал The Next Web. Сами же разработчики комментируют, что их система ИИ справляется с задачей лучше, чем аналогичные машины и люди.

В будущем подобные алгоритмы ИИ можно будет использовать в робототехнике. Благодаря оптимизации систем машинного обучения роботы будут быстрее адаптироваться к окружающей среде и работать эффективнее.